(一) 人工智能的螺旋式进化:从达特茅斯到专家系统的兴衰启示

Yan Li, Tianyi Zhang

前言:大模型时代的现实与追问

2022年 ChatGPT 的爆发点燃了全球 AI 竞赛,两年间技术狂欢与资本角逐将生成式 AI 推向神坛。然而,随着技术能力边界的逐渐显现,业界对通用人工智能(Artificial General Intelligence, AGI)的期望开始回归理性。去年底,OpenAI 高层动荡(首席科学家 Ilya Sutskever 与首席技术官 Mira Murati 纷纷离职),进一步为以大语言模型为核心的 AGI 路径增添了不确定性。与此同时,中国 AI 初创公司 DeepSeek 迅速崛起,以开源模型实现性能突破,但其成果仍局限于工程优化层面。

当技术热潮逐渐退去,人们开始认真思考一个重要问题:在算力和数据已成为基础设施的今天,我们该如何确保人工智能真正服务于全体社会成员?

从起源说起

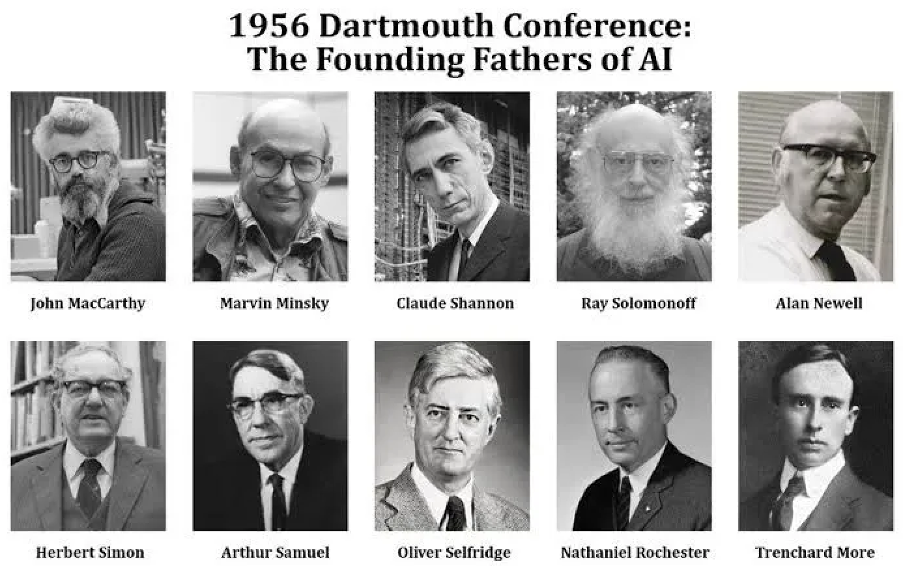

1956年,人工智能(Artificial Intelligence,AI)这一术语于达特茅斯学术研讨会正式诞生。会议上,约翰·麦卡锡(John McCarthy)联合马文·明斯基(Marvin Minsky)、克劳德·香农(Claude Shannon)等人,提出了一个伟大的设想:让计算机模拟人类认知,实现推理、学习和问题求解。

他们定义的一系列智能特征,成为了早期 AI 研究的核心方向:

- 符号推理:利用符号系统进行知识表达与逻辑推理。

- 自然语言处理:研究机器如何理解和使用人类语言。

- 机器学习:探索计算机从经验中学习的可能性。

- 自动推理与问题解决:让机器解决数学问题、逻辑谜题等。

- 自我改进:研究机器如何在运行中学习和优化自身。

- 认知模拟:模仿人类思维过程,与心理学、认知科学交叉发展。

尽管这些设想在当时略显稚嫩,却奠定了 AI 发展的基础,也勾勒出 AI 研究的两条主线:

- 符号主义:基于逻辑规则模拟推理。

- 连接主义:从生物神经网络中汲取灵感模拟人类。

早期 AI 研究在这两条路径上并行展开,并持续至今。

图为 1956 年的达特茅斯会议,与会者们被誉为“人工智能的奠基者”(The Founding Fathers of AI)。该会议是人工智能历史上的里程碑,提出了“人工智能”这一概念,并奠定了该领域的研究基础。图中包括人工智能领域的先驱人物,如约翰·麦卡锡(AI 之父)、马文·明斯基(机器学习研究先驱)、克劳德·香农(信息论之父)等,他们的贡献至今深刻影响着 AI 的发展方向。

早期 AI 的发展

在达特茅斯会议后的首个 10 年,人工智能的研究取得了许多引人注目的成就,美国迅速形成了三大 AI 研究中心,分别在不同领域取得了惊人进展:

-

卡耐基梅隆大学(CMU)

赫伯特·西蒙(Herbert A. Simon)和艾伦·纽厄尔(Allen Newell)开发了通用问题求解器(General Problem Solver, GPS),明确了符号逻辑在 AI 中的支撑作用,并首次将计算机科学应用在心理学领域。 -

国际商业机器公司(IBM)

亚瑟·塞缪尔(Arthur Samuel)开发了自学习西洋跳棋程序,标志着机器学习的早期突破,使 AI 迈向动态学习。 -

麻省理工学院(MIT)

约翰·麦卡锡和马文·明斯基等人推动了专家系统与逻辑推理的符号 AI,并开发了一度成为符号 AI 编程标准的 LISP 语言(LISt Processing)。

这一时期,由于计算资源有限,符号 AI 依靠规则编码和知识库成为主流。例如:

- 通用汽车公司(GM) 推出工业机器人 Unimate,开创自动化先河。

- 1966 年,约瑟夫·魏森鲍姆(Joseph Weizenbaum) 开发的 ELIZA 聊天机器人,成为 AI 早期人机交互的代表。

萧条波折与第一次 AI 寒冬

然而,AI 发展并非一帆风顺。初期的 AI 研究遭遇技术瓶颈,如:

- 符号 AI 受限于“组合爆炸”问题,导致计算量随着问题规模增长而指数级上升。

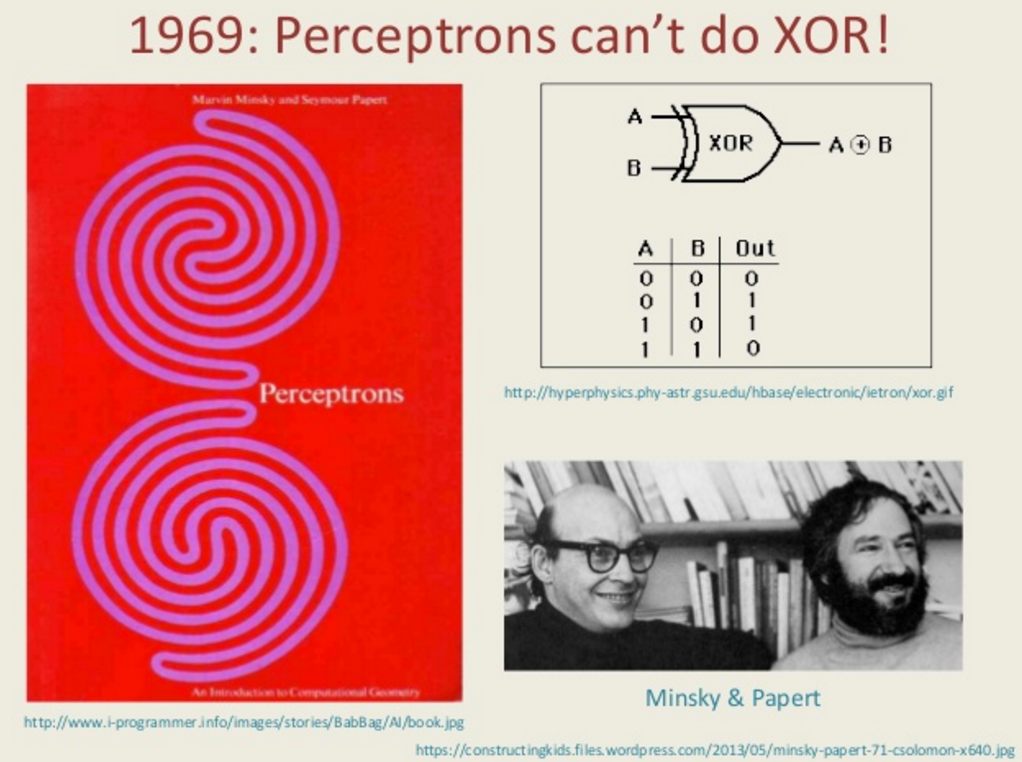

- 1969年,马文·明斯基(Marvin Minsky)和西摩·派普特(Seymour Papert) 在《感知器》一书中指出,单层感知器无法解决非线性分类任务,比如 XOR 问题。这一批评导致神经网络研究停滞。

此外,美国政府资助的 机器翻译项目失败,导致公众对 AI 失去信任。最终,1973年,英国与美国政府削减 AI 研究资金,AI 进入第一次寒冬期。

第二次兴旺发展与寒冬

事物的发展总是可以看作复数波的叠加态,尽管通用推理 AI 的研究陷入低谷,专注于在特定领域中模仿人类专家决策能力的 AI 和专家系统却在逐渐兴起。专家系统源于符号 AI,通过模拟人类专家的知识和推理能力,帮助计算机在特定领域做出决策。

早在 1950 年代末至 1960 年代,部分 AI 研究者就提出了 “知识是智能的关键” 这一核心观点,认为智能行为需要依赖大量领域知识,而不仅仅是推理能力。随着通用推理 AI 的研究陷入瓶颈,研究者们开始意识到知识比推理机制更重要,并倡导智能系统的关键在于如何构建和利用知识库。

DENDRAL 和 MYCIN:专家系统的起源

1965 年,斯坦福大学的 DENDRAL 系统 诞生,由 爱德华·费根鲍姆(Edward Feigenbaum) 和 约书亚·莱德伯格(Joshua Lederberg) 领导开发,专门用于化学分析,帮助解析有机分子结构。其成功表明计算机不仅能计算,还能进行专家级分析。

随后,费根鲍姆团队开发了 MYCIN,用于诊断血液感染病并推荐抗生素治疗方案。MYCIN 引入了 不确定性推理 和 基于规则的推理,增强了 AI 处理复杂任务的能力。

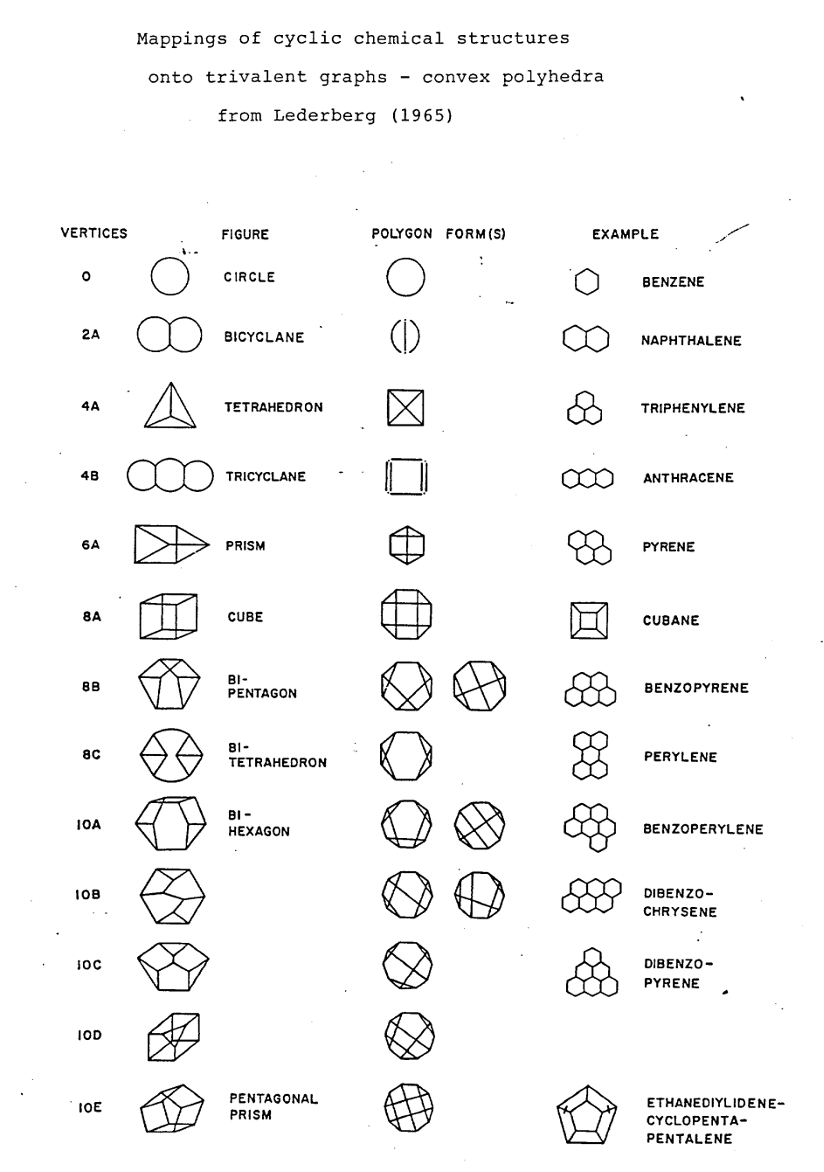

图为化学分子中的环状结构映射到三价图和凸多面体之间的关系。图表按顶点数量分类,展示了从简单的苯环到更复杂的多环芳烃分子的拓扑结构,以及如何通过图论进行建模。

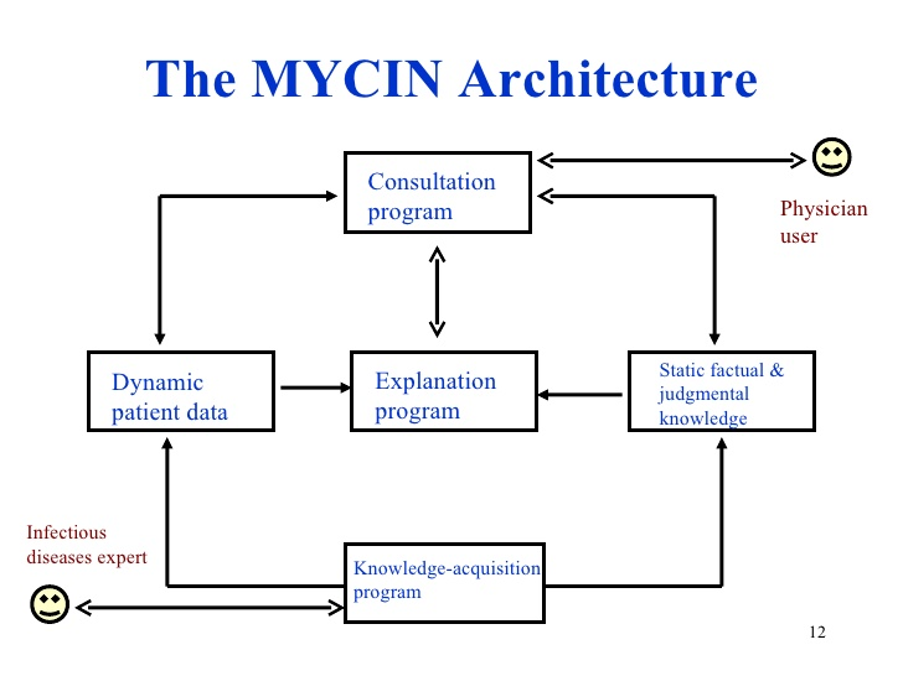

图为 MYCIN 如何整合动态病人数据、静态知识和人机交互,最终实现一个早期专家系统的功能闭环。

DENDRAL 和 MYCIN 的成功表明,专家系统在特定领域中能够超越通用推理系统。这一理念催生了更多应用。例如:

- SRI International 开发的 PROSPECTOR 系统成功用于地质勘探。

- CMU 为 数字设备公司(DEC) 开发的 XCON 专家系统,用于 自动配置计算机系统,减少错误配置导致的退货、维修和人工检查,每年节省 4000 万美元。

1980 - 1985 年间,全球在 AI 领域投资超过 10 亿美元,专家系统成为 AI 商业化的重要突破口。

图为 Osborne 1,被广泛认为是世界上第一台成功的便携式个人电脑。这台计算机由 Osborne Computer Corporation 于 1981 年推出。专家系统的发展需要专门的工具和语言(如 CLISP 和 LISP 机器),而个人计算机(如 Osborne 1)则推动了操作系统(CP/M、MS-DOS)和开发工具的快速普及。

第五代计算机项目:AI 的再次寒冬

日本的 第五代计算机项目(Fifth Generation Computer Systems, FGCS) 试图突破符号 AI 的瓶颈,但由于目标过于激进,最终未能达到预期,成为 AI 领域的重大挫折。政府与企业相继削减投资,许多专家系统项目被搁置,AI 研究再度陷入低谷。

在这一时期,人工智能的发展面临两大核心挑战:

- 交互性(Interaction)问题 —— 传统 AI 方法主要模拟人类深思熟虑的决策过程,却难以实现人与环境的动态交互,使其在现实应用中受限。

- 扩展性(Scaling Up)问题 —— 早期 AI 方法更适用于构建特定领域的专家系统,但缺乏通用性,难以扩展到更大规模、跨领域的复杂系统。

这些问题导致多个 AI 研究计划未能达到预期,人工智能领域再次进入了 “AI 寒冬”。

以史为鉴:人工智能的螺旋式进化

人工智能的 第一阶段 至此告一段落。从 1956 年 达特茅斯会议 的理论探索,到 符号 AI 和专家系统的兴起,AI 先后经历了两次繁荣与低谷。每一次技术突破都伴随着市场与社会需求的推动,而每一次寒冬则促使研究者重新思考 AI 的发展方向。

如今,许多 AI 研究路径仍能看到历史的影子。例如:

- 智能体(Agent) 可被视为更高级、具备交互能力的专家系统。

- 当前最有希望实现 通用人工智能 的 多模态大模型,与智能体的关系正如当年通用逻辑 AI 与专家系统的关系 —— 一者追求通用,一者强调专精。

- 神经符号人工智能(Neuro-Symbolic AI) 结合了神经网络的模式识别能力与符号逻辑的可解释性,弥补二者的局限,构建更健壮、更可解释的 AI 系统。

📌 纵观历史,AI 的每次飞跃不仅依赖理论突破,更由 市场与社会需求 驱动。历史证明,AI 的价值不在于理论完备性,而在于解决现实问题的能力。

也正因如此,当专家系统陷入知识获取瓶颈时,市场立即将目光转向 数据驱动的机器学习。

📌 下一篇,我们将回到 1986 年,从 反向传播算法(Backpropagation) 开始,讲述人工智能如何突破专家系统的困境,并借由一场数据与算力驱动的革命,最终从机器学习发展为今天影响全球的深度学习时代。

扫描下方二维码,加入 AIHH 社区,共同探索AI赋能生活的无限可能