(二) 人工智能的演进:计算与数据支撑的技术范式转变

Yan Li, Tianyi Zhang

20 世纪 60 年代,神经网络曾被视为 AI 的未来,但 1969 年 马文·明斯基(Marvin Minsky) 和 西摩·派普特(Seymour Papert) 在《感知器(Perceptrons)》一书中指出,单层感知器无法解决非线性分类问题(如 XOR),多层感知器又缺乏有效的训练方法,导致神经网络研究在接下来的十年陷入低谷。而在多层感知器的训练方面,保罗·沃博斯(Paulo Werbos) 在 1970 年博士论文中提出用链式法则计算梯度的想法,被认为是反向传播(Backpropagation) 算法的雏形,但由于实验限制没有受到关注。

然而,70-80年代计算机硬件的持续进步为后续神经网络的复兴提供了土壤。1976 年英特尔(Intel)推出 8086 处理器;同年超级计算机 Cray-1 采用向量计算提升数据处理能力;1980 年,IBM 推出 1GB 硬盘x,降低了数据存储成本;1979 年 Oracle 发布关系型数据库(Relational Database Management System,RDBMS) ,革新数据管理;1983 年 ARPANET 采用 TCP/IP 协议,促进数据共享;1986年,MIT 开发的 Connection Machine(CM-1) 专门用于神经网络计算; 。到 1986 年,计算机算力提升 100 倍,存储容量增长 40 倍,数据处理能力大幅跃升。

神经网络与统计学习:计算智能的两条路径

20 世纪 60 年代,神经网络曾被视为 AI 的未来,但 1969 年 马文·明斯基(Marvin Minsky) 和 西摩·派普特(Seymour Papert) 在《感知器(Perceptrons)》一书中指出,单层感知器无法解决非线性分类问题(如 XOR),多层感知器又缺乏有效的训练方法,导致神经网络研究在接下来的十年陷入低谷。而在多层感知器的训练方面,保罗·沃博斯(Paulo Werbos) 在 1970 年博士论文中提出用链式法则计算梯度的想法,被认为是反向传播(Backpropagation) 算法的雏形,但由于实验限制没有受到关注。

然而,70-80 年代计算机硬件的持续进步为后续神经网络的复兴提供了土壤。1976 年英特尔(Intel)推出 8086 处理器;同年超级计算机 Cray-1 采用向量计算提升数据处理能力;1980 年,IBM 推出 1GB 硬盘,降低了数据存储成本;1979 年 Oracle 发布关系型数据库(Relational Database Management System,RDBMS),革新数据管理;1983 年 ARPANET 采用 TCP/IP 协议,促进数据共享;1986 年,MIT 开发的 Connection Machine(CM-1) 专门用于神经网络计算。到 1986 年,计算机算力提升 100 倍,存储容量增长 40 倍,数据处理能力大幅跃升。

图为 Thinking Machines Corporation 在 1980 年代开发的 Connection Machine CM-1/CM-2 超级计算机,专为人工智能、模拟计算和数据分析任务设计。

在这样的背景下,杰弗里·辛顿(Geoffrey Hinton)等人在1986 年的《自然》期刊上发表的反向传播算法(Backpropagation)使多层感知器(Multilayer Perceptron,MLP) 具备了可行的训练方法。同年,杰弗里·辛顿还设计出循环神经网络(Recurrent Neural Network,RNN) 处理时间序列数据,而 Yann LeCun 在 1989 年结合反向传播开发和卷积神经网络(Convolutional Neural Network,CNN)LeNet-5,进行动计算机视觉研究。至此,CNN 和 RNN 作为神经网络的核心架构正式确立。

受限于计算资源,神经网络在当时仍难以规模化应用。于是在这一空白期里,统计学习开始崭露头角,推动机器学习从理论探索向实际应用转变。20世纪80-90年代,决策树(CART)支撑金融风险评估与客户分群;支持向量机(SVM)突破了生物医药领域的基因表达模式分类;隐马尔可夫模型(HMM)赋能IBM、AT&T的语音交互系统;贝叶斯网络(Bayesian Networks)重塑了医疗诊断决策流程与金融欺诈检测模型;马尔可夫随机场(Markov Random Fields, MRFs)则通过图像分割与模式识别技术,在医学影像分析与工业质检领域开辟新市场。

这些统计学习方法并未因后来深度学习(Deep Learning)的崛起而消失,反而持续推动生成式 AI、强化学习、因果推理等研究方向。从神经网络的衰落到统计学习的崛起,AI 研究在数据和计算的双重驱动下完成了一次重大转折,为 21 世纪的深度学习崛起埋下伏笔。

统计学习主导 AI,机器学习迈向应用

从 1996 到 2009 年,一方面来讲,计算机硬件的进步和数据规模的爆炸式增长,使 AI 从理论研究迈向工程化与商业化。另一方面,统计学习逐渐取代符号主义 AI,使机器学习从实验室走向实际应用。

在计算能力方面,1989 年 Intel 80486 处理器 首次集成 浮点运算单元(FPU),大幅提升了计算效率;2005 年,Intel 和 AMD 推出双核处理器,开启了多核计算时代;NVIDIA 于 1999 年发布首款 GeForce GPU,被AI 研究人员发现其并行计算能力可大幅提升 AI 模型的训练速度;2006 年,NVIDIA 推出 CUDA(Compute Unified Device Architecture),使 GPU 具备通用计算能力;2008 年,NVIDIA又发布了Tesla GPU 系列,专门用于高性能计算,进一步推动 AI 研究。

图为击败国际象棋世界冠军卡斯帕罗夫的 IBM 深蓝(DeepBlue)计算机。

在数据存储与管理方面,2000 年代初,硬盘容量从 20GB 增长至 1TB。2005 年,闪存技术(Flash Memory) 发展,固态硬盘(SSD) 提高数据存取速度。2007 年,Amazon 推出 AWS S3,推动数据存储向云端迁移。同时,数据管理方面出现了分布式存储读取和实时数据流管理等技术,支撑后期机器学习模型训练所需的海量数据管理。

最后则是互联网普及带来的数据爆炸。1991 年,蒂姆·伯纳斯-李(Tim Berners-Lee) 发明 万维网(WWW),并于 1995 年商业化,数据增长开始加速。进入 2000 年代中期,Web 2.0 则彻底改变了互联网格局,用户从信息的被动接受者变成内容创造者。2005 年,YouTube 上线,视频成为互联网的主要内容形态,为 AI 在图像、视频分析领域创造了更丰富的数据源。2008 年,Facebook 存储规模突破 2PB(Petabyte)。自此,数据成为 AI 研究最重要的燃料。

图为闪存技术中闪迪 Cruzer TitaniumU盘的印刷电路板上的Samsung闪存(左)慧荣科技(Silicon Motion)主控芯片(右)

这期间,基于统计学习的机器学习算法逐渐发展成熟并走向业界。比如2001 年,利奥·布雷曼(Leo Breiman) 提出随机森林(Random Forest),提升决策树的泛化能力,广泛应用于金融、医疗、工业等领域;2003 年,LASSO 回归(LASSO Regression) 被提出,提高了模型的可解释性。这些方法在后来也在特征选择、模型稳定性和深度学习优化方面起到了重要作用。同时,深度学习开始崭露头角。2006 年,杰弗里·辛顿提出深度信念网络(DBN),但仅停留在实验阶段。

回顾 1996-2009 这 14 年,AI 的发展轨迹十分清晰:计算能力的跃升和数据规模的爆炸式增长,共同推动了 AI 进入新的阶段。从 CPU 到 GPU,从机械硬盘到固态硬盘,从 Web 1.0 到 Web 2.0,每一项技术的突破不仅重塑了 AI 研究的格局,更直接推动了接下来深度学习的崛起。

GPU 计算与互联网推动 AI 变革: 深度学习的复兴

2009 年后,深度学习(Deep Learning) 凭借GPU算力和数据爆炸带来的技术突破,逐步取代传统统计机器学习,成为 AI 研究的核心,并在 计算机视觉、自然语言处理(NLP)、语音识别、自动驾驶、推荐系统 等领域取得突破,AI 迎来从学术研究到产业化的关键变革。

这一切源于2009 年,Google 开始利用 GPU 训练神经网络。自此, AI 研究进入一个全新的阶段。2012 年,AlexNet 在 ImageNet 竞赛中首次用 GPU 加速训练,刷新图像识别精度,展示了 GPU 在神经网络计算中的潜力。随后,NVIDIA 推出高性能 GPU,提升深度学习训练速度。同年,AWS、Google Cloud 发展云 AI 计算,使研究不再受限于本地算力。

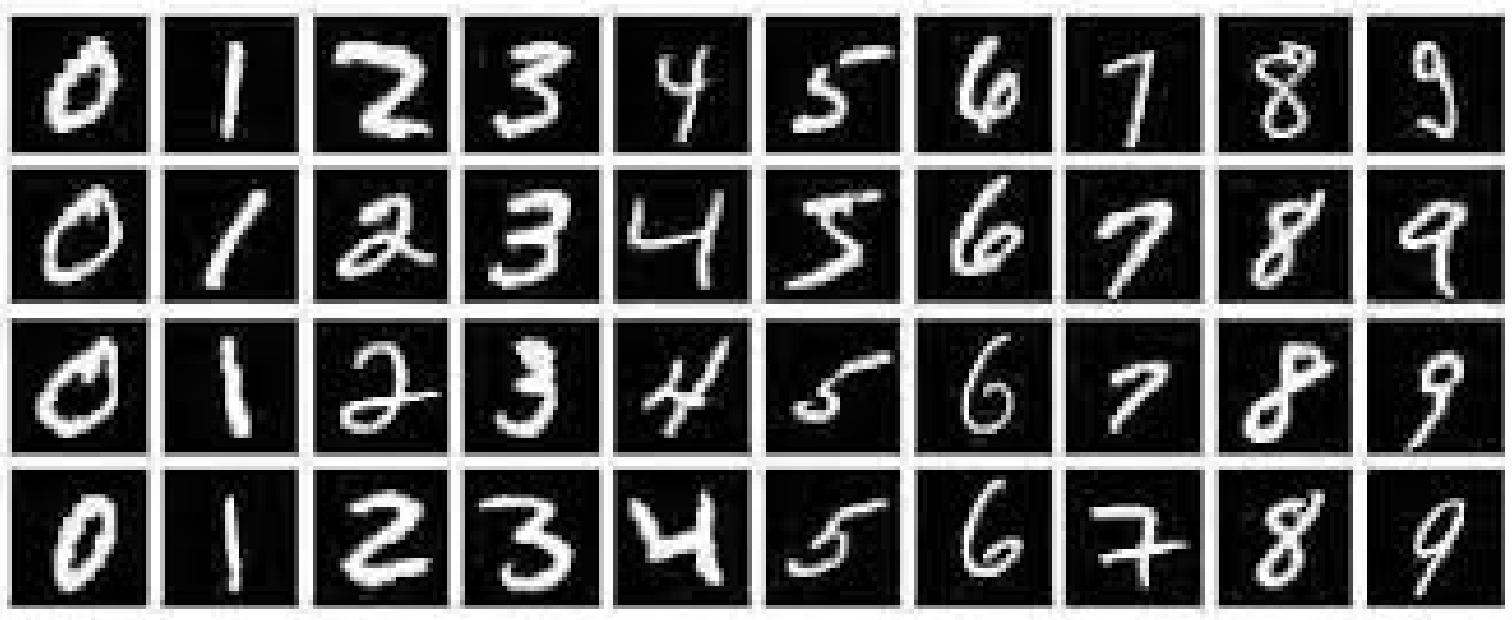

而在数据层面上,ImageNet图像分类数据集(1400 万张图像)在 2010 年开源;2014 年,微软发布目标检测的COCO 数据集(33 万张图片)。在 NLP 领域,Google 开源 One Billion Word 语料库,Wikipedia 和 Common Crawl 也成为关键数据源。不仅如此,社交媒体(Twitter、YouTube、Instagram)产生的海量数据,成为倍受研究者们欢迎的数据来源。在数据量爆炸式增长的同时,出现了众包数据标注平台(如 Amazon Mechanical Turk),解决了数据处理瓶颈。

图为 ImageNet 数据集。

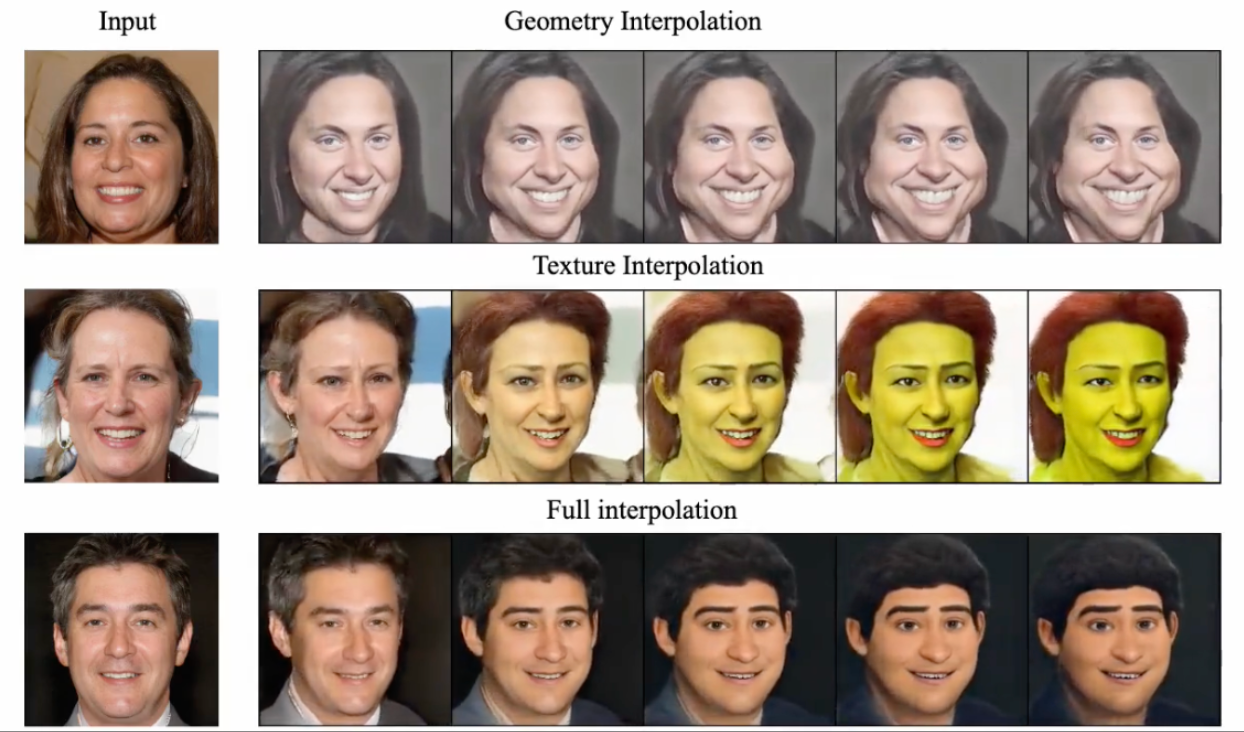

得益于 GPU的应用发展和数据爆炸,深度学习在这一时期取得一系列关键突破。Hinton 提出的 Dropout 可以解决过拟合问题,Nair & Hinton 的 ReLU 加速了AI模型训练的稳定性;伊恩·古德费洛(Ian Goodfellow) 提出的 生成对抗网络(GAN) 开启 AI 在图像生成、风格迁移的新探索。2013年,Google 提出 Word2Vec,极大提升 NLP 任务中的语言理解能力。2015 年,ResNet(微软) 解决了神经网络退化问题,ImageNet 误差率降至 3.6%,AI 模型首次超越人类水平。

图为AI风格迁移示例。

最终,深度学习的变化吸引了全球科技巨头。谷歌在 2014 年 以 4 亿美元收购 DeepMind,并投资 12 亿美元 用于 AI 计算基础设施。AWS 在 2015 年投入超过 20 亿美元 扩展 AI 云计算基础设施。全球 AI 投资金额从 2011 年的 300 亿美元增长到 2015 年的 680 亿美元,其中企业 AI 研发投入超 500 亿美元,风险投资对 AI 初创企业的投资额达 180 亿美元,AI 产业迎来前所未有的增长期。

计算能力的提升、数据的增长、算法的优化以及科技企业的推动,让 AI 在 2015 年后进入高速发展阶段,深度学习全面崛起,迈向 Transformer 时代和大语言模型 的前夜。

图为Alexa 语音助手。

数据与计算:支撑 AI 迈向智能新时代

从 1986 年到 2015 年,人工智能的发展始终在数据与计算的双轮支撑下加速前进。如果说市场需求和社会需求是驱动人工智能发展的外部动力,决定了 AI 发展的方向,那么数据和计算则是 AI 发展的内部支撑,决定了 AI 发展的能力上限。从神经网络的复兴,到统计学习的主导,再到深度学习的全面崛起,每一次 AI 的范式转变,都伴随着算力的飞跃和数据规模的指数级增长。

然而,光有计算能力、数据规模和市场需求的推动,仍不足以让人工智能达到如今席卷全球、渗透各行各业的普及度。AI 之所以能在短短数十年内实现从学术研究到产业化落地,并引发前所未有的技术革命,离不开开源文化的兴起。当计算能力、数据规模和算法创新交汇,AI 发展已不再局限于少数科技巨头,而是进入了一个由全球开发者、研究机构、企业和社区共同塑造的时代。TensorFlow、PyTorch、Hugging Face 等开源工具的兴起,让 AI 研究和应用门槛大幅降低,使AI 技术快速普及,参与到每个人的生活。

AI 的演进,不止于计算,不止于数据,更造就了一个开放共创的时代。 在下一篇,我们将聚焦开源如何塑造 AI 生态,探讨开源框架、数据集、社区协作如何加速 AI 技术迭代,并推动 AI 从实验室走向真正的普惠化应用。

扫描下方二维码,加入 AIHH 社区,共同探索AI赋能生活的无限可能!