(三) 开源生态:重构人工智能发展格局的终极力量

Yan Li, Tianyi Zhang

人工智能(AI)在过去十年间取得了惊人的发展,改变了众多的行业模式。在前两篇文章中,我们探讨了(一)市场需求和社会需求作为外部驱动力如何推动AI的快速演进,以及(二)数据和计算能力如何作为AI的内部支撑,决定其能力上限。然而,除了需求与资源这两个核心要素外,AI的高速发展还得益于一个至关重要的催化剂——开源。开源不仅加速了AI技术的创新和普及,还降低了技术壁垒,使全球研究者、企业和开发者能够更高效地共享知识、改进算法,并将AI应用于各种场景。本文将回顾并分析2015年至今的AI的发展历程,讲述开源如何成为重构人工智能发展格局的终极力量。

什么是开源?从自由软件运动到现代软件生态

开源(Open Source)指源代码公开,允许任何人使用的软件或技术。其发展历程可追溯至计算机早期的共享文化,并经历了自由软件运动(Free Software Movement)、企业化开源生态,以及当今 AI 与开源的结合。然而,软件版权问题始终伴随开源发展,形成了 Copyleft(版权左) 与 Copyright(版权右) 的长期争论。

Copyright 和 Copyleft 之争始于20 世纪 80 年代。其中,Copyright 源于 1980 年美国通过的《计算机软件版权法》,确立了软件代码的版权保护。随着软件的商业化,企业开始利用 Copyright 限制源代码访问,引发了自由软件运动,并催生了由产生GNU(GNU’s Not Unix)计划和自由软件基金会(Free Software Foundation,FSF)创立为代表事件的软件自由理念。

图为中华人民共和国国家版权局颁发的 计算机软件著作权登记证书,证明特定软件的著作权归属。

1989 年,理查德·斯托曼(Richard Stallman) 发布 GNU 通用公共许可证(GNI General Public License,GPL),正式引入 Copyleft 概念,要求所有衍生作品保持开源。虽然GPL后来 成为 Linux 等关键项目的核心许可协议,奠定了现代开源生态的基础,可在当时,由于 Copyleft 的严格要求,部分企业对其望而却步。

图为理查德·斯托曼(Richard Stallman)在美国马萨诸塞州剑桥市麻省理工学院(MIT)发布 GNU GPLv3 第一版草案时发表讲话。

“开源(Open Source)” 概念在 20 世纪 90 年代兴起,为适应企业需求出现了更灵活的许可模式以及对应的软件和平台。于是Apache、MySQL、PHP 等开源技术广泛应用,而 Linux 等系统成为行业关键基础设施。2008 年,GitHub 诞生,加速了开源生态的发展,降低了软件协作门槛,并促进企业与社区的融合,使开源逐渐成为行业主流。

当今,开源生态与商业化实践的动态平衡已成为技术演进的核心特征。GPL 许可的严格性使其在现代软件中使用率下降,而更宽松的 MIT、Apache等许可协议则更易于商业应用。这种演变在AI时代被赋予新的维度——开源边界从传统的操作系统和数据库,扩展至算法架构、预训练模型、开发工具链乃至训练数据集,构成AI技术栈的基础设施。2015 年前,开源技术已成为 AI 发展的推动力。而在深度学习兴起后,开源更是成为助推 AI 爆炸式增长的关键力量。

从框架开源到模型共享:AI技术爆炸的底层推力

自 2015 年以来,开源成为推动 AI 技术爆炸性发展的关键力量。如果没有开源的深度学习框架、开放模型和社区协作,AI 不可能发展得如此迅速。尽管 AI 研究一直受益于学术界的共享文化,但真正的大规模代码开源始于 2000 年代至 2010 年代初,Scikit-learn(2007)、Theano(2010)、Caffe(2013) 等工具的出现,降低了机器学习的门槛,但深度学习仍是小众领域。

2015 年,Google 发布 TensorFlow,开放了企业级深度学习工具,彻底改变了 AI 的开发方式。2016 年,Facebook(现 Meta)推出 PyTorch,凭借动态计算图和直观 API,在学术界迅速普及,并最终超越 TensorFlow,成为产业界的主流框架。2018 年,Hugging Face 进入 NLP 领域,推动了开源 AI 共享模式,使 BERT(2018)、GPT-2(2019) 等预训练模型得以广泛应用,加速了大规模语言模型(LLM)的发展。2019 年,OpenAI 发布 GPT-2,尽管最初以“安全”为由推迟完整开源,但最终还是向社区开放,进一步降低了 AI 研究的学习成本,推动创新。

从2020年起,开源在AI 进入大模型时代后,开源变得更加重要。OpenAI 在 2021 年发布 GPT-3,但不再开源模型参数,引发社区对 AI 技术封闭化的担忧。好在和它形成鲜明对比的是,Meta 在 2023 年开源 LLaMA,Mistral 也推出 Mistral 7B,推动开源 AI 发展。同时,Stable Diffusion(2022) 等开源生成模型的兴起,让 AI 生成艺术、自动图像编辑等应用普及。这样的开源项目让全球的开发者能够在已有基础上创新,而不是被少数大公司掌控 AI 的发展方向。这种共享精神使得 AI 领域进入了前所未有的繁荣期,新模型、新方法层出不穷。

图为 AI 生成的 NFT(非同质化代币)艺术作品,采用 Bored Ape Yacht Club(BAYC)系列风格,在数字艺术和区块链社区中广受关注。

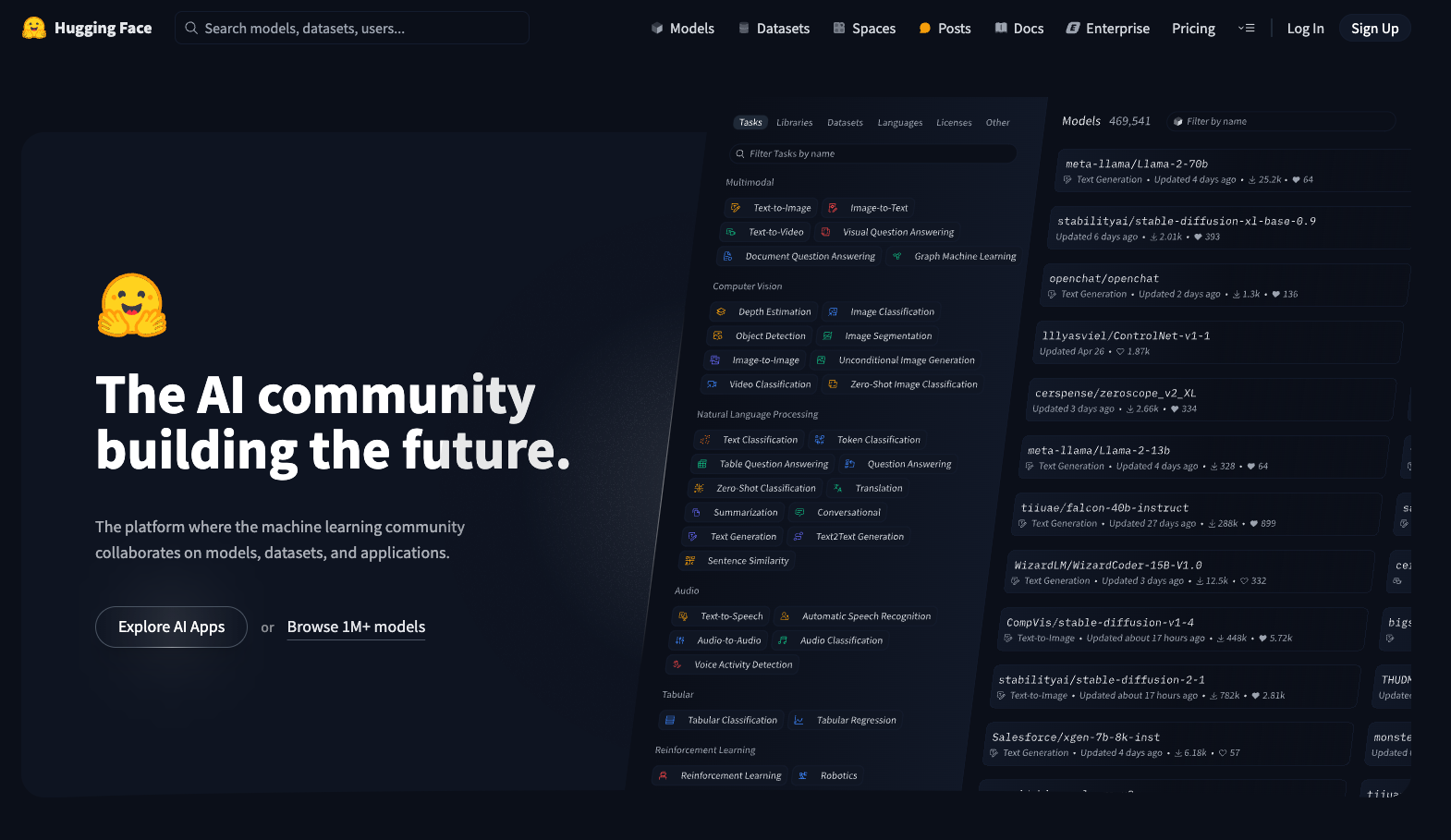

开源不仅让 AI 研究变得更加开放和高效,还促进了 AI 技术的全球合作。Hugging Face 的 Transformers 库使得全球研究者能够在几行代码内使用他人发布的最先进的AI模型;GitHub 和 arXiv 促进论文与代码的即时共享,加快 AI 技术传播速度;EleutherAI 和 Stability AI 等社区驱动组织则通过众包模式训练开源大模型,减少 AI 领域的集中化风险。这种开放协作模式,让 AI 研究从少数企业的实验室走向全球开发者的共同创新。

然而,一些 AI 巨头却在尝到开源红利后逐步转向闭源,试图垄断先进技术,OpenAI 便是最具代表性的例子 ,在2015 年成立时承诺推动 AI 技术民主化,并发布了一系列开源工具,却在获得微软投资后改变战略。2020 年,GPT-3 仅提供 API 访问,而 2023 年 GPT-4 更是完全闭源,与微软深度绑定,使其成为Azure 生态的一环。这标志着 OpenAI 从一个倡导技术共享的研究机构,转型为以商业利益为核心的封闭公司。

未来,开源与闭源的博弈仍将持续,但趋势已逐渐明朗。真正推动 AI 进步的,并非少数科技巨头的封闭决策,而是全球开发者共同构建的开源生态。Meta、Mistral、Hugging Face 等公司坚定支持开源,并推动 AI 去中心化发展。对于他们来说,开源不仅是技术策略,更是一种信念——它确保 AI 发展更加公平、透明、可持续。与此同时,以DeepSeek为代表的新的开源力量也在迅速崛起。事实将证明,封闭只会减缓创新,而真正属于未来的,是那些愿意共享技术、拥抱社区的开源 AI。

图为Hugging Face 平台首页。Hugging Face作为 AI 社区的核心,支持机器学习开发者在模型、数据集和应用上进行协作。

DeepSeek的开源突围:分布式创新打破技术垄断壁垒

当 OpenAI 自 2023 年以来彻底对 GPT-4 和GPT-o1系列模型进行闭源封锁时,全球 AI 社区仿佛陷入了一场关于技术垄断的集体焦虑。然而,中国团队 DeepSeek 选择了一条与之截然相反的道路:他们不仅公开了全新一代大语言模型 DeepSeek-v3 和 DeepSeek-r1 的完整参数,还采用商业友好的MIT开源协议许可证,向所有开发者开放,并允许用户通过蒸馏技术借助 R1 训练其他模型。相比之下,OpenAI这种封闭策略不仅显得守旧,而且在算法透明化浪潮下日益暴露出无法挽回的弱势。

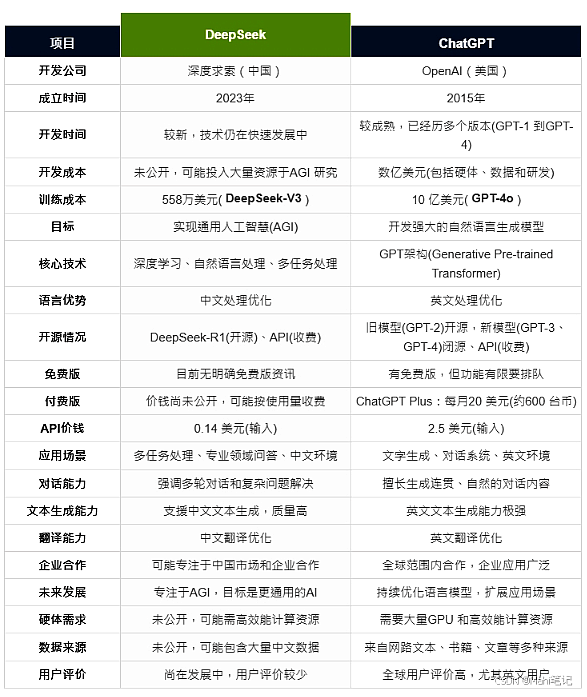

官方测评显示,DeepSeek-R1 在数学、编程和多学科知识类任务上的表现已经与 OpenAI-o1-1217 这种商业闭源大模型平分秋色,甚至在某些难度极高的推理基准上呈现出追平甚至部分超越的迹象。而DeepSeek-R1模型训练成本仅为560万美元,远低于美国一众科技巨头公司在人工智能技术上高达数亿甚至数十亿美元的投入。定价方面,DeepSeek-R1面向开发者的服务定价为每百万token(输入字符串)1—4元,仅为GPT-o1的1/30左右。

图为DeepSeek(深度求索)与 ChatGPT 在开发公司、成立时间、技术架构、训练成本、应用场景、推理能力等方面的对比。数据来源于https://blog.csdn.net/Mahi6868/article/details/145706373,仅供参考。

与开源项目相比,闭源策略逐渐显露出诸多问题。大量开发者更倾向于使用拥有完整可见性的开源模型进行二次开发,而GPT-4 在发布后的一年多时间里,由于外界对其内部机制知之甚少,导致创新陷入停滞,并未迎来明显的代际升级,API 的调用量增速也开始放缓。相对比下, DeepSeek 的透明性使得模型在社区审计、动态内容过滤、溯源水印等多方面都取得了突破性进展。

当开源浪潮不断冲击封闭堡垒之际,许多组织和社区开始加速推动全球 AI 生态的去中心化。DeepSeek 主张的分布式创新理念,恰恰契合了当下对技术和数据主权的追求:当模型蒸馏与强化学习等技术变得愈发成熟,所谓“技术壁垒”正逐渐被开源社区的力量所攻破。

开源共生:人工智能文明进阶的必由之路

当人工智能技术逐渐演变为数字时代的"新电力",开源与闭源的角力已不仅是技术路径之争,更是关乎人类智能文明演进方向的根本抉择。

历史经验反复证明,封闭系统终将陷入内卷,而开源生态的网状进化能力注定引领变革。从Hugging Face模型库的日均百万次下载,再到DeepSeek-R1以1/30成本实现闭源模型的性能对标——这些现象共同勾勒出一个去中心化的未来图景:技术壁垒在开源协议下土崩瓦解,算力资源借分布式网络自由流动,创新权力从巨头服务器回归社区笔记本。

开源的终极价值不仅在于降低技术门槛,更在于构建"人类智能共同体"的制度框架——让算法接受集体监督,让创新遵循开放标准让AI的便利覆盖更广泛群体。这或许才是人工智能发展的终极答案:当AI成为人类共同财富,技术才能真正服务于每个人。

扫描下方二维码,加入 AIHH 社区,共同探索AI赋能生活的无限可能!